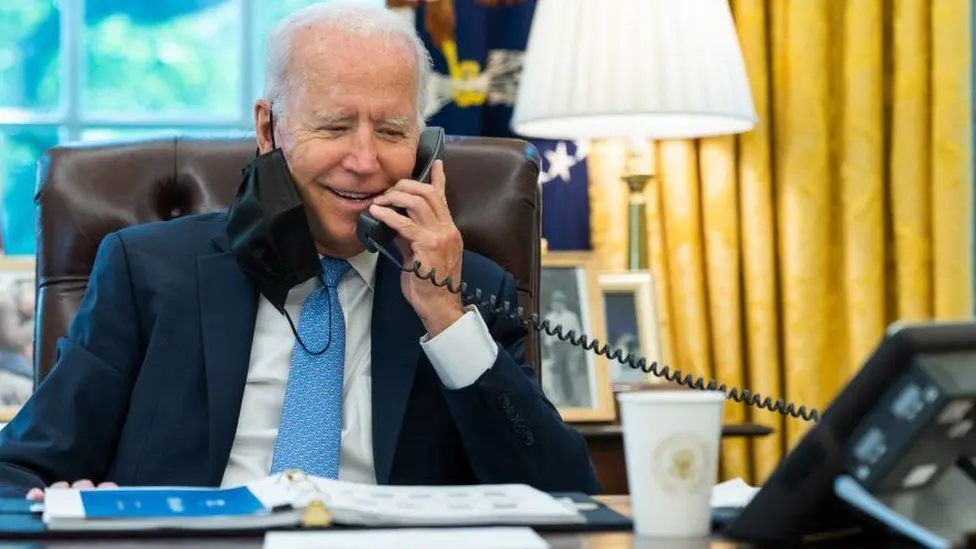

«Важно сохранить свой голос для ноябрьских выборов», — говорилось в записанном сообщении потенциальным избирателям в прошлом месяце, накануне первичных выборов демократов в Нью-Гэмпшире. Это было очень похоже на президента.

Но голоса не нужно сохранять, и голос принадлежал не Джо Байдену, а, скорее всего, убедительному клону ИИ.

Этот инцидент довел опасения по поводу аудиофейков с использованием искусственного интеллекта до апогея — и технология становится все более мощной, как я узнал, когда обратился по этому поводу в компанию по кибербезопасности.

Мы организовали звонок, который выглядел следующим образом:

«Привет, Крис, это Рэйф Пиллинг из Secureworks. Я перезваниваю по поводу потенциального собеседования. Как дела?»

Я сказал, что все идет хорошо.

«Приятно это слышать, Крис», — сказал Пиллинг. «Я ценю, что вы обратились к нам. Я понимаю, что вы заинтересованы в методах клонирования голоса. Это правильно?»

Да, я ответил. Меня беспокоит злонамеренное использование этой технологии.

«Абсолютно, Крис. Я разделяю ваше беспокойство. Давайте найдем время для интервью», — ответил он.

Но это был не настоящий Пиллинг. Это была демонстрация, организованная Secureworks, системы искусственного интеллекта, способной звонить мне и реагировать на мои реакции. Также была попытка имитировать голос Пиллинга.

Послушайте клонированный голос в последнем выпуске Tech Life на BBC Sounds.

Миллионы звонков

«Я немного похож на пьяного австралийца, но это было довольно впечатляюще», — сказал настоящий Пиллинг после окончания демонстрации. Это было не совсем убедительно. Перед ответами, которые могли бы кричать «робот!», были паузы. для осторожных.

Звонки были совершены с использованием свободно доступной коммерческой платформы, которая, как утверждается, способна отправлять «миллионы» телефонных звонков в день с использованием ИИ-агентов, звучащих как человек.

В своем маркетинге компания предполагает, что потенциальное использование может включать колл-центры и опросы.

Коллега Пиллинга, Бен Джейкоб, привел эту технологию в качестве примера — не потому, что фирму, стоящую за продуктом, обвиняют в чем-то неправильном. Это не так. Но чтобы показать возможности систем нового поколения. И хотя ее сильной стороной был разговор, а не подражание, другая система, которую продемонстрировал Джейкоб, создавала достоверные копии голосов, основанные лишь на небольших фрагментах аудио, взятых с YouTube.

С точки зрения безопасности Пиллинг считает способность системы быстро развертывать тысячи подобных диалоговых ИИ важным и тревожным событием. «Клонирование голоса — это вишенка на торте», — говорит он мне.

В настоящее время телефонным мошенникам приходится нанимать армию дешевой рабочей силы для управления мини-колл-центром или просто самим проводить много времени по телефону. ИИ может все это изменить.

Если да, то это отражает влияние ИИ в более широком смысле.

«Главное, что мы видим в этих технологиях искусственного интеллекта, — это возможность повысить эффективность и масштаб существующих операций», — говорит он.

Дезинформация

В связи с предстоящими в этом году крупными выборами в Великобритании, США и Индии также возникают опасения, что аудиодипфейки (так называются сложные фальшивые голоса, которые может создавать ИИ) могут быть использованы для создания дезинформации, направленной на манипулирование демократическими результатами.

Высокопоставленные британские политики, как и политики других стран, включая Словакию и Аргентину, подвергались аудиофейкам. Национальный центр кибербезопасности прямо предупредил об угрозах, которые фейки искусственного интеллекта представляют для следующих выборов в Великобритании.

Лорена Мартинес, работающая в фирме Logically Facts, занимающейся борьбой с дезинформацией в Интернете, рассказала BBC, что дипфейки не только становятся все более распространенными, но и их сложнее проверить, чем изображения, созданные искусственным интеллектом.

«Если кто-то хочет замаскировать аудио-дипфейк, он может это сделать, и в распоряжении фактчекеров меньше технологических решений и инструментов», — сказала она.

Пиллинг добавляет, что к моменту разоблачения фейка зачастую уже широко распространена.

Мартинес, который некоторое время работал в Твиттере, борясь с дезинформацией, утверждает, что через год, когда более половины населения мира придет на избирательные участки, компании, занимающиеся социальными сетями, должны делать больше и усилить борьбу с дезинформацией.

Она также призвала разработчиков технологии клонирования голоса «подумать о том, как их инструменты могут быть повреждены», прежде чем запускать их, вместо того, чтобы «реагировать на их неправильное использование, что мы видели с чат-ботами с искусственным интеллектом».

Избирательная комиссия, наблюдатель за выборами в Великобритании, сообщила мне, что новые способы использования ИИ «вызывают явную обеспокоенность по поводу того, чему избиратели могут и не могут доверять тому, что они видят, слышат и читают во время выборов».

Компания заявляет, что объединилась с другими наблюдателями, чтобы попытаться понять возможности и проблемы ИИ.

Но Сэм Джефферс, соучредитель компании Who Targets Me, которая отслеживает политическую рекламу, утверждает, что важно помнить, что демократические процессы в Великобритании довольно устойчивы.

Он говорит, что мы также должны остерегаться опасности чрезмерного цинизма, поскольку дипфейки заставляют нас не верить достоверной информации.

«Мы должны быть осторожны, чтобы избежать ситуации, когда вместо того, чтобы предупреждать людей об опасностях ИИ, мы непреднамеренно заставляем людей терять веру в то, чему они могут доверять», — говорит Джеффрис.