Apple заявляет, что ее объявление об автоматических инструментах для обнаружения сексуального насилия над детьми на iPhone и iPad было «довольно запутанным».

5 августа компания представила новое программное обеспечение для обнаружения изображений, которое может предупреждать Apple, если в ее хранилище iCloud загружены известные незаконные изображения.

Группы по конфиденциальности раскритиковали эту новость, а некоторые заявили, что Apple создала бэкдор безопасности в своем программном обеспечении.

Компания заявляет, что ее объявление было «неправильно понято».

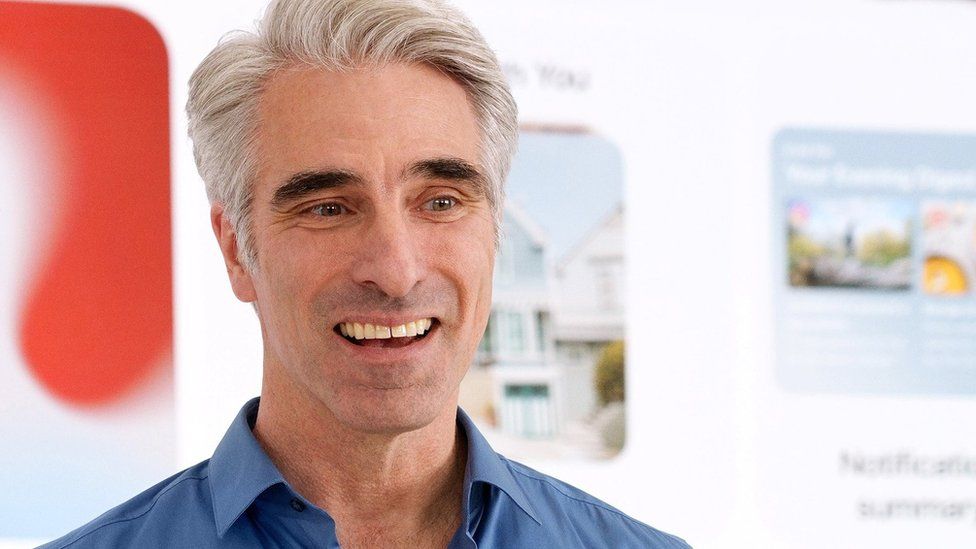

«Мы хотим, чтобы это стало для всех более понятным», — сказал глава программного обеспечения Apple Крейг Федериги в интервью Wall Street Journal.

Он сказал, что — оглядываясь назад — введение двух функций одновременно было «рецептом для такого рода путаницы».

Какие новые инструменты?

Apple анонсировала два новых инструмента, предназначенных для защиты детей. Сначала они будут развернуты в США.

Обнаружение изображения

Первый инструмент может идентифицировать известные материалы о сексуальном насилии над детьми (CSAM), когда пользователь загружает фотографии в хранилище iCloud.

Национальный центр США по делам пропавших без вести и эксплуатируемых детей (NCMEC) ведет базу данных известных незаконных изображений жестокого обращения с детьми. Он хранит их в виде хэшей — цифровых «отпечатков пальцев» нелегального материала.

Поставщики облачных услуг, такие как Facebook, Google и Microsoft, уже сверяют изображения с этими хэшами, чтобы убедиться, что люди не передают CSAM.

Apple решила реализовать аналогичный процесс, но заявила, что будет выполнять сопоставление изображений на iPhone или iPad пользователя, прежде чем оно будет загружено в iCloud.

Г-н Федериги сказал, что iPhone не будет проверять такие вещи, как фотографии ваших детей в ванной или порнографию.

По его словам, система может сопоставить только «точные отпечатки пальцев» определенных известных изображений сексуального насилия над детьми.

Если пользователь пытается загрузить несколько изображений, которые соответствуют отпечаткам пальцев жестокого обращения с детьми, его учетная запись будет помечена Apple, чтобы можно было просмотреть конкретные изображения.

Г-н Федериги сказал, что пользователь должен будет загрузить около 30 совпадающих изображений, прежде чем эта функция будет активирована.

Фильтрация сообщений

В дополнение к инструменту iCloud Apple также объявила о родительском контроле, который пользователи могут активировать в учетных записях своих детей.

Если эта функция активирована, система будет проверять фотографии, отправленные ребенком или ему, через приложение Apple iMessage.

Если система машинного обучения решит, что фотография содержит наготу, она закроет фотографию и предупредит ребенка.

Родители также могут выбрать получение оповещения, если ребенок решит просмотреть фотографию.

Критика

Группы конфиденциальности разделяют опасения, что технология может быть расширена и использована авторитарными правительствами для слежки за своими гражданами.

Глава WhatsApp Уилл Кэткарт назвал шаг Apple «очень тревожным», а американский осведомитель Эдвард Сноуден назвал iPhone «шпионским телефоном».

Г-н Федериги сказал, что «звуковой байт», распространившийся после объявления, заключался в том, что Apple сканирует iPhone в поисках изображений.

«Это не то, что происходит», — сказал он Wall Street Journal.

«Мы очень позитивно и решительно относимся к тому, что мы делаем, и мы видим, что это широко неправильно понимается».

Эти инструменты должны быть добавлены в новые версии iOS и iPadOS в конце этого года.