Глобальная группа экспертов по искусственному интеллекту и специалистов по данным выпустила новую добровольную основу для безопасной разработки продуктов искусственного интеллекта.

Всемирный фонд этических данных насчитывает 25 000 членов, включая сотрудников, работающих в различных технологических гигантах, таких как Meta, Google и Samsung.

Структура содержит контрольный список из 84 вопросов, которые разработчики должны рассмотреть в начале проекта ИИ.

Фонд также приглашает общественность задавать свои вопросы.

В нем говорится, что все они будут рассмотрены на следующей ежегодной конференции.

Фреймворк был выпущен в форме открытого письма, что, по-видимому, является предпочтительным форматом сообщества ИИ. У него сотни подписей.

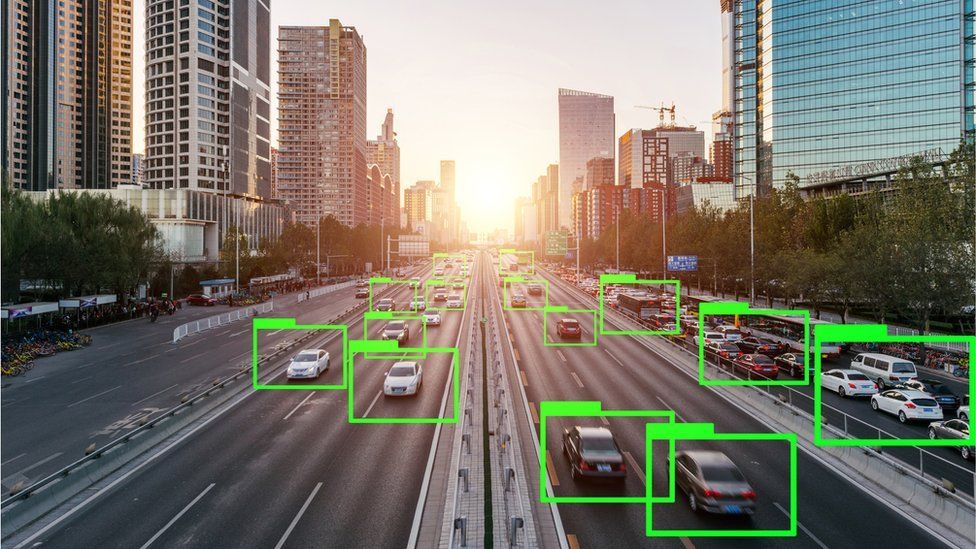

ИИ позволяет компьютеру действовать и реагировать почти так же, как если бы он был человеком.

Компьютеры могут получать огромные объемы информации и обучаться выявлять в ней закономерности, чтобы делать прогнозы, решать проблемы и даже учиться на собственных ошибках.

Помимо данных, ИИ опирается на алгоритмы — списки правил, которым необходимо следовать в правильном порядке для выполнения задачи.

Фонд был запущен в 2018 году и представляет собой некоммерческую глобальную группу, объединяющую людей, работающих в сфере технологий и научных кругов, для изучения разработки новых технологий.

Его вопросы к разработчикам включают в себя то, как они предотвратят предвзятость продукта ИИ и как они будут действовать в ситуации, когда результат, созданный инструментом, приводит к нарушению закона.

На этой неделе теневой министр внутренних дел Иветт Купер заявила, что Лейбористская партия привлечет к уголовной ответственности тех, кто преднамеренно использует инструменты ИИ в террористических целях.

Премьер-министр Риши Сунак назначил Яна Хогарта, технологического предпринимателя и инвестора в области ИИ, руководителем рабочей группы по ИИ. На этой неделе Хогарт сказал мне, что хочет «лучше понять риски, связанные с этими передовыми системами искусственного интеллекта», и привлечь к ответственности компании, которые их разрабатывают.

Другие соображения в этой структуре включают законы о защите данных на различных территориях, ясно ли пользователю, что он взаимодействует с ИИ, и справедливо ли обращались с людьми, которые вводят или маркируют данные, используемые для обучения продукта.

Полный список разделен на три главы: вопросы для отдельных разработчиков, вопросы для совместной работы команды и вопросы для людей, тестирующих продукт.

Вот некоторые из 84 вопросов:

- Чувствую ли я, что меня торопят или заставляют вводить данные из сомнительных источников?

- Поможет ли команда людей, которые работают над отбором обучающих данных из разнообразного набора знаний и опыта, уменьшить предвзятость при выборе данных?

- Каково предполагаемое использование модели после ее обучения?

«Мы находимся на этой сцене дикого запада»

«Мы находимся на стадии Дикого Запада, где все просто: «Выбрось это на улицу и посмотри, что из этого получится». сказал Винс Линч, основатель фирмы IV.AI и советник правления World Ethical Data Foundation. Ему пришла в голову идея каркаса.

«И теперь те трещины, которые есть в фундаменте, становятся все более очевидными, поскольку люди ведут разговоры об интеллектуальной собственности, о том, как права человека рассматриваются в отношении ИИ и о том, что они делают».

Если, например, модель была обучена с использованием некоторых данных, защищенных авторским правом, просто удалить их нельзя — возможно, придется заново обучать всю модель.

«Иногда это может стоить сотни миллионов долларов. Ошибиться невероятно дорого», — сказал Линч.

Были предложены и другие добровольные рамки для безопасной разработки ИИ.

Маргарет Вестагер, комиссар ЕС по вопросам конкуренции, возглавляет усилия ЕС по созданию добровольного кодекса поведения с правительством США, в соответствии с которым компании, использующие или разрабатывающие ИИ, подпишутся под набором стандартов, которые не имеют обязательной юридической силы.

Willo — это рекрутинговая платформа из Глазго, которая недавно запустила инструмент искусственного интеллекта для своих услуг.

Фирма заявила, что на сбор достаточного количества данных для ее создания ушло три года.

Соучредитель Эндрю Вуд сказал, что в какой-то момент фирма решила приостановить свою разработку в ответ на этические проблемы, высказанные ее клиентами.

«Мы не используем наши возможности искусственного интеллекта для принятия каких-либо решений. Принятие решений остается за работодателем», — сказал он.

«Есть определенные области, где ИИ действительно применим, например, планирование собеседований… но принятие решения о том, двигаться ли дальше [с наймом кандидата] или нет, всегда будет оставлено на усмотрение человека. обеспокоены».

Соучредитель Юан Кэмерон сказал, что прозрачность для пользователей была для него важной частью структуры Foundation.

«Если кто-то использует ИИ, вы не можете прокрасться через черный ход и притвориться, что этот контент создал человек», — сказал он.

«Должно быть ясно, что это было сделано с помощью технологии искусственного интеллекта. Это действительно выделялось для меня».

Подпишитесь на Зои Клейнман в Твиттере @zsk.